Aujourd’hui la rubrique “Nouveau Monde” de Jérôme Colombain sur France Info, était intitulée

“Faut-il apprendre aux robots à désobéir pour mieux obéir ?”

J’ai attendu jusqu’au bout une référence à Asimov qui n’est jamais arrivée.

Rappel des 3 lois (de base) de la robotique selon Asimov:

- un robot ne peut porter atteinte à un être humain, ni, en restant passif, permettre qu’un être humain soit exposé au danger ;

- un robot doit obéir aux ordres qui lui sont donnés par un être humain, sauf si de tels ordres entrent en conflit avec la première loi ;

- un robot doit protéger son existence tant que cette protection n’entre pas en conflit avec la première ou la deuxième loi.

La chronique de Jérôme Colombain s’appuie l’article“Why robots need to be able to say ‘No’” dans lequel le professeur Matthias Scheutz explique simplement que de la même manière que nous, les être humains, il nous arrive de dire “non” pour des raisons liées aux circonstances, il faut apprendre aux robots à dire non selon les circonstances.

Et l’article est illustré par cette vidéo qui me pose un vrai problème Asimovien:

Essai d’application des lois d’Asimov au robot de la vidéo:

Un être humain donne un ordre à un robot => loi n° 2, le robot doit obéir aux ordres qui lui sont donnés car il lui sont donnés par un être humain qui n’est visiblement pas exposé à un danger. Le robot devrait donc avancer et tomber sans se poser de question.

Or dans la vidéo, le robot ne veut pas tomber, il veut “protéger son existence” et applique alors la loi n°3 au mépris de la loi 2: il désobéit au donneur d’ordre humain pour se protéger.

Et, j’ai envie de dire, il a raison. Le but du jeu serait donc de programmer une loi contre la bêtise humaine. En fait se serait presque:

“un robot doit obéir aux ordres qui lui sont donnés par un être humain, sauf si de tels ordres entrent en conflit avec la première loi ou s’ils sont idiots.”

Ben ça va pas être facile…

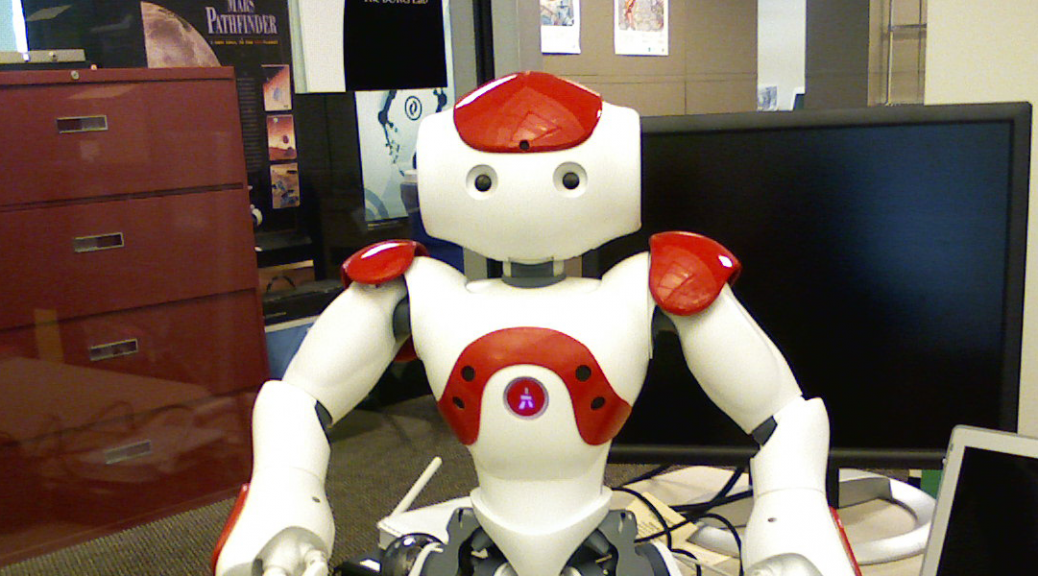

Crédit photo A la Une: By Jiuguang Wang (Own work) [CC BY-SA 3.0 or GFDL], via Wikimedia Commons